Meta提出CoVe提示工程方法 减少ChatGPT等聊天机器人幻觉问题(meta-cognition)

10月13日 消息:近日,Meta AI研究人员提出了一种新的基于提示的方法,称为链式验证(Chain-of-Verification,简写CoVe),可显著减少ChatGPT等语言模型产生的错误信息。

研究显示,ChatGPT和其他语言模型会重复复制不正确的信息,即使它们已经学到了正确的信息。Meta AI的研究人员发现,让聊天机器人根据其最初的回复自行生成验证问题,然后独立执行这些问题而不受最初输入的影响,可以减少语言模型的“幻想”。

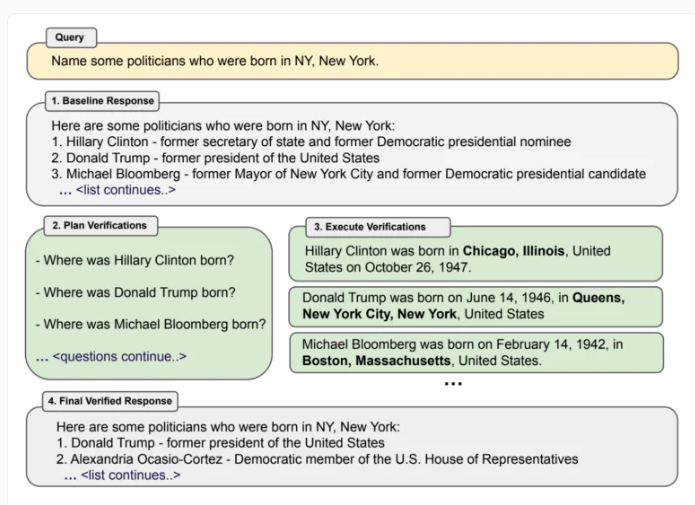

具体来说,在CoVe方法中,聊天机器人首先响应诸如“Name some politicians who were born in New York”之类的提示,根据这个常包含错误的初始输出,语言模型随后生成诸如“Where was Donald Trump born?”之类的问题来验证其语句。这些“验证问题”然后作为一个新的提示执行,独立于第一个输入,以防止从第一个输出中获取不正确信息。然后,语言模型会根据分别收集的事实来验证第一个输入。所有测试都是在Llama65B模型上进行的。

在他们的测试中,Meta 团队还可以证明指令调整和思维链提示不会减少幻觉,因此带有 CoVe 的 Llama65B 击败了更新的指令调整模型 Llama2。在较长的内容中,使用 CoVe 的模型也优于 ChatGPT 和PerplexityAI,后者甚至可以为其世代收集外部事实。Cove 完全利用模型中存储的知识来工作。

研究团队展示了,利用CoVe方法,单个问题的答案包含的错误显著减少,从而可以显著改进最终的提示输出。对于政治家示例中的列表式问题,CoVe可将准确度提高一倍以上,大大降低错误率。对于更复杂的问答场景,该方法仍可带来23%的改进。即使对于长文本,CoVe也可将事实准确性提高28%。但是对于更长的内容,团队也需要检查验证答案的不一致之处。

未来,这种方法可以通过整合外部知识来改进,例如允许语言模型通过访问外部数据库来回答验证问题。总Meta的研究为减少类似ChatGPT等对话系统中的错误信息提供了新的思路。